Кластерный анализ

Большинство исследователей склоняются к тому, что впервые термин «кластерный анализ» (англ. cluster — гроздь, сгусток, пучок) был предложен математиком Р.Трионом . Впоследствии возник ряд терминов, которые в настоящее время принято считать синонимами термина «кластерный анализ»: автоматическая классификация; ботриология.

Кластерный анализ — это многомерная статистическая процедура, выполняющая сбор данных, содержащих информацию о выборке объектов, и затем упорядочивающая объекты в сравнительно однородные группы (кластеры)(Q-кластеризация, или Q-техника, собственно кластерный анализ). Кластер — группа элементов, характеризуемых общим свойством, главная цель кластерного анализа — нахождение групп схожих объектов в выборке. Спектр применений кластерного анализа очень широк: его используют в археологии, медицине, психологии, химии, биологии, государственном управлении, филологии, антропологии, маркетинге, социологии и других дисциплинах. Однако универсальность применения привела к появлению большого количества несовместимых терминов, методов и подходов, затрудняющих однозначное использование и непротиворечивую интерпретацию кластерного анализа. Орлов А. И. предлагает различать следующим образом:

Задачи и условия

Кластерный анализ выполняет следующие основные задачи:

- Разработка типологии или классификации.

- Исследование полезных концептуальных схем группирования объектов.

- Порождение гипотез на основе исследования данных.

- Проверка гипотез или исследования для определения, действительно ли типы (группы), выделенные тем или иным способом, присутствуют в имеющихся данных.

Независимо от предмета изучения применение кластерного анализа предполагает следующие этапы:

- Отбор выборки для кластеризации. Подразумевается, что имеет смысл кластеризовать только количественные данные.

- Определение множества переменных, по которым будут оцениваться объекты в выборке, то есть признакового пространства.

- Вычисление значений той или иной меры сходства (или различия) между объектами.

- Применение метода кластерного анализа для создания групп сходных объектов.

- Проверка достоверности результатов кластерного решения.

Кластерный анализ предъявляет следующие требования к данным:

- показатели не должны коррелировать между собой;

- показатели не должны противоречить теории измерений;

- распределение показателей должно быть близко к нормальному;

- показатели должны отвечать требованию «устойчивости», под которой понимается отсутствие влияния на их значения случайных факторов;

- выборка должна быть однородна, не содержать «выбросов».

Можно встретить описание двух фундаментальных требований предъявляемых к данным — однородность и полнота:

Однородность требует, чтобы все сущности, представленные в таблице, были одной природы. Требование полноты состоит в том, чтобы множества I и J представляли полную опись проявлений рассматриваемого явления. Если рассматривается таблица в которой I — совокупность, а J — множество переменных, описывающих эту совокупность, то должно должно быть представительной выборкой из изучаемой совокупности, а система характеристик J должна давать удовлетворительное векторное представление индивидов i с точки зрения исследователя .

Если кластерному анализу предшествует факторный анализ , то выборка не нуждается в «ремонте» — изложенные требования выполняются автоматически самой процедурой факторного моделирования (есть ещё одно достоинство — z-стандартизация без негативных последствий для выборки; если её проводить непосредственно для кластерного анализа, она может повлечь за собой уменьшение чёткости разделения групп). В противном случае выборку нужно корректировать.

Типология задач кластеризации

Типы входных данных

В современной науке применяется несколько алгоритмов обработки входных данных. Анализ путём сравнения объектов, исходя из признаков, (наиболее распространённый в биологических науках) называется Q-типом анализа, а в случае сравнения признаков, на основе объектов — R-типом анализа. Существуют попытки использования гибридных типов анализа (например, RQ-анализ), но данная методология ещё должным образом не разработана.

Цели кластеризации

- Понимание данных путём выявления кластерной структуры. Разбиение выборки на группы схожих объектов позволяет упростить дальнейшую обработку данных и принятия решений, применяя к каждому кластеру свой метод анализа (стратегия «разделяй и властвуй »).

- Сжатие данных . Если исходная выборка избыточно большая, то можно сократить её, оставив по одному наиболее типичному представителю от каждого кластера.

- Обнаружение новизны (англ. novelty detection). Выделяются нетипичные объекты, которые не удаётся присоединить ни к одному из кластеров.

В первом случае число кластеров стараются сделать поменьше. Во втором случае важнее обеспечить высокую степень сходства объектов внутри каждого кластера, а кластеров может быть сколько угодно. В третьем случае наибольший интерес представляют отдельные объекты, не вписывающиеся ни в один из кластеров.

Во всех этих случаях может применяться иерархическая кластеризация , когда крупные кластеры дробятся на более мелкие, те в свою очередь дробятся ещё мельче, и т. д. Такие задачи называются задачами таксономии . Результатом таксономии является древообразная иерархическая структура. При этом каждый объект характеризуется перечислением всех кластеров, которым он принадлежит, обычно от крупного к мелкому.

Методы кластеризации

Общепринятой классификации методов кластеризации не существует, но можно отметить солидную попытку В. С. Берикова и Г. С. Лбова . Если обобщить различные классификации методов кластеризации, то можно выделить ряд групп (некоторые методы можно отнести сразу к нескольким группам и потому предлагается рассматривать данную типизацию как некоторое приближение к реальной классификации методов кластеризации):

- Вероятностный подход. Предполагается, что каждый рассматриваемый объект относится к одному из k классов. Некоторые авторы (например, А. И. Орлов) считают, что данная группа вовсе не относится к кластеризации и противопоставляют её под названием «дискриминация», то есть выбор отнесения объектов к одной из известных групп (обучающих выборок).

- Подходы на основе систем искусственного интеллекта. Весьма условная группа, так как методов AI очень много и методически они весьма различны.

- Логический подход. Построение дендрограммы осуществляется с помощью дерева решений.

- Теоретико-графовый подход.

- Графовые алгоритмы кластеризации

- Иерархический подход. Предполагается наличие вложенных групп (кластеров различного порядка). Алгоритмы в свою очередь подразделяются на агломеративные (объединительные) и дивизивные (разделяющие). По количеству признаков иногда выделяют монотетические и политетические методы классификации.

- Иерархическая дивизивная кластеризация или таксономия. Задачи кластеризации рассматриваются в количественной таксономии.

- Другие методы. Не вошедшие в предыдущие группы.

- Статистические алгоритмы кластеризации

- Ансамбль кластеризаторов

- Алгоритмы семейства KRAB

- Алгоритм, основанный на методе просеивания

- DBSCAN и др.

Подходы 4 и 5 иногда объединяют под названием структурного или геометрического подхода, обладающего большей формализованностью понятия близости . Несмотря на значительные различия между перечисленными методами все они опираются на исходную «гипотезу компактности»: в пространстве объектов все близкие объекты должны относиться к одному кластеру, а все различные объекты соответственно должны находиться в различных кластерах.

Формальная постановка задачи кластеризации

Пусть — множество объектов, — множество номеров (имён, меток) кластеров. Задана функция расстояния между объектами . Имеется конечная обучающая выборка объектов . Требуется разбить выборку на непересекающиеся подмножества, называемые кластерами, так, чтобы каждый кластер состоял из объектов, близких по метрике , а объекты разных кластеров существенно отличались. При этом каждому объекту приписывается номер кластера .

Алгоритм кластеризации — это функция , которая любому объекту ставит в соответствие номер кластера . Множество в некоторых случаях известно заранее, однако чаще ставится задача определить оптимальное число кластеров, с точки зрения того или иного критерия качества кластеризации.

Кластеризация (обучение без учителя) отличается от классификации (обучения с учителем) тем, что метки исходных объектов изначально не заданы, и даже может быть неизвестно само множество .

Решение задачи кластеризации принципиально неоднозначно, и тому есть несколько причин (как считает ряд авторов):

- не существует однозначно наилучшего критерия качества кластеризации. Известен целый ряд эвристических критериев, а также ряд алгоритмов, не имеющих чётко выраженного критерия, но осуществляющих достаточно разумную кластеризацию «по построению». Все они могут давать разные результаты. Следовательно, для определения качества кластеризации требуется эксперт предметной области, который бы мог оценить осмысленность выделения кластеров.

- число кластеров, как правило, неизвестно заранее и устанавливается в соответствии с некоторым субъективным критерием. Это справедливо только для методов дискриминации, так как в методах кластеризации выделение кластеров идёт за счёт формализованного подхода на основе мер близости.

- результат кластеризации существенно зависит от метрики, выбор которой, как правило, также субъективен и определяется экспертом. Но стоит отметить, что есть ряд рекомендаций к выбору мер близости для различных задач.

Применение

В биологии

В биологии кластеризация имеет множество приложений в самых разных областях. Например, в биоинформатике с помощью нее анализируются сложные сети взаимодействующих генов, состоящие порой из сотен или даже тысяч элементов. Кластерный анализ позволяет выделить подсети, узкие места, концентраторы и другие скрытые свойства изучаемой системы, что позволяет в конечном счете узнать вклад каждого гена в формирование изучаемого феномена.

В области экологии широко применяется для выделения пространственно однородных групп организмов, сообществ и т. п. Реже методы кластерного анализа применяются для исследования сообществ во времени. Гетерогенность структуры сообществ приводит к возникновению нетривиальных методов кластерного анализа (например, метод Чекановского).

В общем стоит отметить, что исторически сложилось так, что в качестве мер близости в биологии чаще используются меры сходства , а не меры различия (расстояния).

В социологии

При анализе результатов социологических исследований рекомендуется осуществлять анализ методами иерархического агломеративного семейства, а именно методом Уорда, при котором внутри кластеров оптимизируется минимальная дисперсия, в итоге создаются кластеры приблизительно равных размеров. Метод Уорда наиболее удачен для анализа социологических данных. В качестве меры различия лучше квадратичное евклидово расстояние, которое способствует увеличению контрастности кластеров. Главным итогом иерархического кластерного анализа является дендрограмма или «сосульчатая диаграмма». При её интерпретации исследователи сталкиваются с проблемой того же рода, что и толкование результатов факторного анализа — отсутствием однозначных критериев выделения кластеров. В качестве главных рекомендуется использовать два способа — визуальный анализ дендрограммы и сравнение результатов кластеризации, выполненной различными методами.

Визуальный анализ дендрограммы предполагает «обрезание» дерева на оптимальном уровне сходства элементов выборки. «Виноградную ветвь» (терминология Олдендерфера М. С. и Блэшфилда Р. К. ) целесообразно «обрезать» на отметке 5 шкалы Rescaled Distance Cluster Combine, таким образом будет достигнут 80 % уровень сходства. Если выделение кластеров по этой метке затруднено (на ней происходит слияние нескольких мелких кластеров в один крупный), то можно выбрать другую метку. Такая методика предлагается Олдендерфером и Блэшфилдом.

Теперь возникает вопрос устойчивости принятого кластерного решения. По сути, проверка устойчивости кластеризации сводится к проверке её достоверности. Здесь существует эмпирическое правило — устойчивая типология сохраняется при изменении методов кластеризации. Результаты иерархического кластерного анализа можно проверять итеративным кластерным анализом по методу k-средних. Если сравниваемые классификации групп респондентов имеют долю совпадений более 70 % (более 2/3 совпадений), то кластерное решение принимается.

Проверить адекватность решения, не прибегая к помощи другого вида анализа, нельзя. По крайней мере, в теоретическом плане эта проблема не решена. В классической работе Олдендерфера и Блэшфилда «Кластерный анализ» подробно рассматриваются и в итоге отвергаются дополнительные пять методов проверки устойчивости:

В информатике

- Кластеризация результатов поиска — используется для «интеллектуальной» группировки результатов при поиске файлов , веб-сайтов , других объектов , предоставляя пользователю возможность быстрой навигации, выбора заведомо более релевантного подмножества и исключения заведомо менее релевантного — что может повысить юзабилити интерфейса по сравнению с выводом в виде простого сортированного по релевантности списка .

- Clusty — кластеризующая поисковая машина компании Vivísimo

- Nigma — российская поисковая система с автоматической кластеризацией результатов

- Quintura — визуальная кластеризация в виде облака ключевых слов

- Сегментация изображений (англ. image segmentation) — Кластеризация может быть использована для разбиения цифрового изображения на отдельные области с целью обнаружения границ (англ. edge detection) или распознавания объектов .

- Интеллектуальный анализ данных (англ. data mining) — Кластеризация в Data Mining приобретает ценность тогда, когда она выступает одним из этапов анализа данных, построения законченного аналитического решения. Аналитику часто легче выделить группы схожих объектов, изучить их особенности и построить для каждой группы отдельную модель, чем создавать одну общую модель для всех данных. Таким приемом постоянно пользуются в маркетинге, выделяя группы клиентов, покупателей, товаров и разрабатывая для каждой из них отдельную стратегию.

См. также

Примечания

Ссылки

На русском языке

- www.MachineLearning.ru — профессиональный вики-ресурс, посвященный машинному обучению и интеллектуальному анализу данных

На английском языке

- COMPACT — Comparative Package for Clustering Assessment. A free Matlab package, 2006.

- P. Berkhin, Survey of Clustering Data Mining Techniques, Accrue Software, 2002.

- Jain, Murty and Flynn: Data Clustering: A Review, ACM Comp. Surv., 1999.

- for another presentation of hierarchical, k-means and fuzzy c-means see this introduction to clustering . Also has an explanation on mixture of Gaussians.

- David Dowe, Mixture Modelling page — other clustering and mixture model links.

- a tutorial on clustering

- The on-line textbook: Information Theory, Inference, and Learning Algorithms , by David J.C. MacKay includes chapters on k-means clustering, soft k-means clustering, and derivations including the E-M algorithm and the variational view of the E-M algorithm.

- «The Self-Organized Gene» , tutorial explaining clustering through competitive learning and self-organizing maps.

- kernlab — R package for kernel based machine learning (includes spectral clustering implementation)

- Tutorial — Tutorial with introduction of Clustering Algorithms (k-means, fuzzy-c-means, hierarchical, mixture of gaussians) + some interactive demos (java applets)

- Data Mining Software — Data mining software frequently utilizes clustering techniques.

- Java Competitve Learning Application A suite of Unsupervised Neural Networks for clustering. Written in Java. Complete with all source code.

- Machine Learning Software — Also contains much clustering software.

10.1.1 Основные понятия.

Пустьисследуется совокупность объектов,каждый из которых характеризуется  измеренными признаками. Требуетсяразбить эту совокупность на однородныев некотором смысле группы. Приэтом практически отсутствует априорнаяинформация о характере распределения

измеренными признаками. Требуетсяразбить эту совокупность на однородныев некотором смысле группы. Приэтом практически отсутствует априорнаяинформация о характере распределения -мерноговектора

-мерноговектора внутри классов.Полученныев результате разбиения группы обычноназываются кластерами(таксонами, образами),методы их нахождения — кластер-анализом(численной таксономией или распознаваниемобразов с самообучением).

внутри классов.Полученныев результате разбиения группы обычноназываются кластерами(таксонами, образами),методы их нахождения — кластер-анализом(численной таксономией или распознаваниемобразов с самообучением).

Решение задачизаключается в определении естественногорасслоения результатов наблюдений начетко выраженные кластеры, лежащие другот друга на некотором расстоянии. (Можетоказаться, что множество наблюдений необнаруживает естественного расслоенияна кластеры, т.е. образует один кластер).

Обычной формойпредставления исходных данных в задачахкластерного анализа служит матрица

,

,

каждаястрока которой представляет результатыизмерений  рассматриваемых признаков у одного изобъектов.

рассматриваемых признаков у одного изобъектов.

Кластеризацияпредназначенадля разбиения совокупности объектовна однородные группы (кластерыиликлассы). Если данные выборки представитькак точки в признаковом пространстве,то задачакластеризациисводитсяк определению «сгущений точек».

Переводитсяпонятиекластер (cluster)как «скопление», «гроздь».Синонимами термина «кластеризация «являются «автоматическаяклассификация «,»обучение без учителя» и «таксономия».

Целькластеризации — поиск существующихструктур. Кластеризацияявляетсяописательной процедурой, она не делаетникаких статистических выводов, но даетвозможность провести разведочный анализи изучить «структуру данных». Классызаранее не определены, осуществляетсяпоиск наиболее похожих, однородныхгрупп. Кластер можно охарактеризоватькак группу объектов, имеющих общиесвойства.

Характеристикамикластера можно назвать два признака:

внутренняя однородность;

внешняя изолированность.

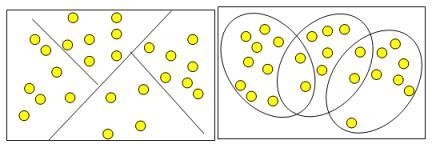

Кластерымогут быть непересекающимися, илиэксклюзивными (non-overlapping, exclusive), ипересекающимися (overlapping). Схематическоеизображение непересекающихся ипересекающихсякластеров данона рис.10.1.

Рис.10.1 Непересекающиеся и пересекающиесякластеры

Термин «кластерныйанализ», впервые введенный Трионом(Tryon) в 1939 году, объединяет более 100различных алгоритмов.

В отличие от задачклассификации, кластерный анализ нетребует априорных предположений онаборе данных, не накладывает ограниченияна представление исследуемых объектов,позволяет анализировать показателиразличных типов данных (интервальныеданные, частоты, бинарные данные). Приэтом необходимо помнить, что переменныедолжны измеряться в сравнимых шкалах.

10.1.2 Характеристики кластера

Кластеримеет следующиематематические характеристики:центр,радиус,среднеквадратическое отклонение,размер кластера.

Каждый объектсовокупности в кластерном анализерассматривается как точка в заданномпризнаковом пространстве. Значениекаждого из признаков у данной единицыслужит ее координатой в этом пространстве.

Центр кластера -это среднее геометрическое место точекв пространстве переменных.

Радиус кластера-максимальное расстояние расположенияточек отцентра кластера.

Еслиневозможно при помощи математическихпроцедур однозначно отнести объект кодному из двух кластеров, то такиеобъекты называютспорными, и обнаруживаетсяперекрытие кластеров. Спорныйобъект -это объект, который по мере сходстваможет быть отнесен к нескольким кластерам.

Размер кластераможетбыть определен либо порадиусу кластера,либо посреднеквадратичному отклонению объектовдля этого кластера. Объект относится ккластеру, если расстояние от объектадо центракластера меньшерадиуса кластера.Если это условие выполняется для двухи более кластеров, объект являетсяспорным.Неоднозначность данной задачи можетбыть устранена экспертом или аналитиком.

Задачи кластеризации в DataMining

Введение вкластерный анализ

Из всей обширной области применения кластерного анализа,например, задачисоциально-экономического прогнозирования.

При анализе и прогнозированиисоциально-экономических явлений исследователь довольно часто сталкивается смногомерностью их описания. Этопроисходит при решении задачи сегментирования рынка, построениитипологии стран по достаточно большому числу показателей, прогнозированияконъюнктуры рынка отдельных товаров, изучении и прогнозировании экономическойдепрессии и многих других проблем.

Методы многомерного анализа — наиболеедейственный количественный инструмент исследования социально-экономическихпроцессов, описываемых большимчисломхарактеристик. К ним относятся кластерный анализ, таксономия, распознаваниеобразов, факторный анализ.

Кластерный анализ наиболееярко отражает черты многомерного анализа в классификации, факторный анализ – висследовании связи.

Иногда подход кластерного анализа называют в литературе численной таксономией,численной классификацией, распознаванием с самообучением и т.д.

Первое применение кластерный анализ нашел в социологии. Названиекластерный анализ происходит от английского слова cluster – гроздь, скопление. Впервые в1939 был определен предмет кластерного анализа и сделано его описаниеисследователем Трионом. Главное назначение кластерного анализа – разбиениемножества исследуемых объектов и признаков на однородные в соответствующемпонимании группы или кластеры. Это означает, что решается задача классификацииданных и выявления соответствующей структуры в ней. Методы кластерного анализаможно применять в самых различных случаях, даже в тех случаях, когда речь идето простой группировке, в которой все сводится к образованию групп по количественномусходству.

Большое достоинство кластерногоанализа в том, что он позволяет производить разбиение объектов не по одномупараметру, а по целому набору признаков. Кроме того, кластерный анализ вотличие от большинства математико-статистических методов не накладывает никакихограничений на вид рассматриваемых объектов, и позволяет рассматриватьмножество исходных данных практически произвольной природы. Это имеет большоезначение, например, для прогнозирования конъюнктуры, когда показатели имеютразнообразный вид, затрудняющий применение традиционных эконометрическихподходов.

Кластерный анализ позволяет рассматривать достаточно большой объеминформации и резко сокращать, сжимать большие массивы социально-экономическойинформации, делать ихкомпактными и наглядными.

Важное значение кластерный анализ имеет применительно к совокупностямвременных рядов, характеризующих экономическое развитие (например,общехозяйственной и товарной конъюнктуры). Здесь можно выделять периоды, когдазначения соответствующих показателей были достаточно близкими, а такжеопределять группы временных рядов, динамика которых наиболее схожа.

Кластерный анализ можно использовать циклически. В этом случаеисследование производится до тех пор, пока не будут достигнуты необходимыерезультаты. При этом каждый цикл здесь может давать информацию, котораяспособна сильно изменить направленность и подходы дальнейшего применениякластерного анализа. Этот процесс можно представить системой с обратной связью.

В задачахсоциально-экономического прогнозирования весьма перспективно сочетаниекластерного анализас другимиколичественными методами (например, с регрессионным анализом).

Как и любой другой метод,кластерный анализ имеет определенные недостаткии ограничения: В частности, состави количество кластеров зависит отвыбираемых критериев разбиения. При сведении исходного массиваданных к более компактному виду могут возникать определенные искажения, а такжемогут теряться индивидуальные черты отдельных объектов за счетзамены их характеристиками обобщенныхзначений параметров кластера. При проведении классификации объектовигнорируется очень часто возможность отсутствия в рассматриваемойсовокупности каких-либо значений кластеров.

В кластерном анализе считается, что:

а) выбранныехарактеристики допускают в принципе желательное разбиение на кластеры;

б) единицыизмерения (масштаб) выбраны правильно.

Выбор масштаба играет большую роль. Как правило, данные нормализуютвычитанием среднего и делением на стандартное отклоненение, так что дисперсияоказывается равной единице.

1.Задача кластеризации

Задача кластеризации заключается в том, чтобы на основании данных,содержащихся во множестве Х, разбитьмножество объектов G на m (m – целое) кластеров (подмножеств) Q 1 ,Q 2 , …,Q m, так, чтобыкаждый объект G j принадлежал одному итолько одному подмножеству разбиения и чтобы объекты, принадлежащие одному итому же кластеру, были сходными, в то время, как объекты, принадлежащие разнымкластерам были разнородными.

Например, пусть G включает n стран, любая из которыххарактеризуется ВНП на душу населения (F 1),числом М автомашин на 1 тысячучеловек (F 2), душевым потреблениемэлектроэнергии (F 3), душевым потреблениемстали (F 4) и т.д. Тогда Х 1 (вектор измерений) представляет собой набор указанныххарактеристик для первой страны, Х 2— для второй, Х 3 длятретьей, и т.д. Задача заключается в том, чтобы разбить страны по уровнюразвития.

Решением задачи кластерного анализа являются разбиения, удовлетворяющиенекоторому критерию оптимальности. Этот критерий может представлять собойнекоторый функционал, выражающий уровни желательности различных разбиений игруппировок, который называют целевой функцией. Например, в качестве целевойфункции может быть взята внутригрупповая сумма квадратов отклонения:

где x j — представляет собойизмерения j-го объекта.

Для решениязадачи кластерногоанализа необходимо определить понятие сходства и разнородности.

Понятно то, что объекты i-ыйи j-ый попадали бы в один кластер,когда расстояние (отдаленность) между точками Х iи Х j было бы достаточномаленьким и попадали бы в разные кластеры, когда это расстояние было быдостаточно большим. Таким образом, попадание в один или разные кластерыобъектов определяется понятием расстояния между Х i и Х j из Ер, где Ер — р-мерное евклидово пространство.Неотрицательная функция d(Х i , Х j) называется функцией расстояния(метрикой), если:

а) d(Х i , Х j)³ 0, для всех Х i и Х j из Ер

б) d(Х i , Х j) = 0,тогда и только тогда, когда Х i = Х j

в) d(Х i , Х j) = d(Х j ,Х i)

г) d(Х i , Х j)£ d(Х i , Х k) + d(Х k ,Х j), где Х j ; Х i и Х k -любые три вектора из Ер.

Значение d(Х i , Х j) для Х iи Х j называется расстояниеммежду Х iи Х j и эквивалентнорасстоянию между G i и G jсоответственно выбранным характеристикам (F 1 , F 2 , F 3 ,…, F р).

Наиболее часто употребляются следующие функции расстояний:

1. Евклидово расстояние d 2 (Х i ,Х j) =

2. l 1 — нормаd 1 (Х i ,Х j) =

3. Супремум — норма d ¥ (Х i , Х j) = sup

k = 1, 2, …, р

4. l p — норма d р (Х i ,Х j) =

Евклидова метрика является наиболее популярной. Метрика l 1наиболее легкая для вычислений. Супремум-норма легко считается и включает всебя процедуру упорядочения, а l p— норма охватывает функции расстояний 1, 2, 3,.

Пусть n измерений Х 1 , Х 2 ,…,Х n представлены в виде матрицыданных размером p´n:

Тогда расстояние между парами векторов d(Х i, Х j) могут быть представлены в виде симметричной матрицырасстояний:

Понятием, противоположным расстоянию, является понятие сходства междуобъектами G i .и G j. Неотрицательнаявещественная функция S(Х i ; Х j) =S ijназывается мерой сходства, если:

1) 0£S(Х i , Х j)1для Х i¹ Х j

2) S(Х i ,Х i) = 1

3) S(Х i ,Х j) = S(Х j ,Х i)

Пары значений мер сходства можно объединить в матрицу сходства:

Величину S ijназываюткоэффициентом сходства.

2. Методыкластеризации

Сегодня существует достаточно много методовкластерного анализа. Остановимся на некоторых из них (ниже приводимые методыпринято называть методами минимальной дисперсии).

Пусть Х— матрица наблюдений: Х = (Х 1 , Х 2 ,…, Х u)и квадрат евклидова расстояния между Х i и Х j определяется по формуле:

![]()

1) Метод полных связей.

Суть данного метода в том, что два объекта,принадлежащих одной и той же группе (кластеру), имеют коэффициент сходства,который меньше некоторого порогового значения S. В терминах евклидова расстояния dэто означает, что расстояние между двумя точками (объектами)кластера не должно превышать некоторого порогового значенияh. Таким образом,h определяет максимально допустимый диаметрподмножества, образующего кластер.

2) Метод максимального локальногорасстояния.

Каждый объект рассматривается какодноточечный кластер. Объекты группируются по следующему правилу: два кластераобъединяются, если максимальное расстояние между точками одного кластера иточками другого минимально. Процедура состоит из n — 1 шагов и результатом являются разбиения, которые совпадают совсевозможными разбиениями в предыдущем методе для любых пороговых значений.

3) МетодВорда.

В этом методе в качестве целевой функции применяют внутригрупповую суммуквадратов отклонений, которая есть ни что иное, как сумма квадратов расстояниймежду каждой точкой (объектом) и средней по кластеру, содержащему этот объект.На каждом шаге объединяются такие два кластера, которые приводят к минимальномуувеличению целевой функции, т.е. внутригрупповой суммы квадратов. Этот методнаправлен на объединение близко расположенных кластеров.

4) Центроидный метод.

Расстояние между двумя кластерами определяется как евклидово расстояниемежду центрами (средними) этих кластеров:

d 2 ij =(`X –`Y) Т (`X –`Y)Кластеризация идет поэтапно на каждом из n–1шагов объединяют два кластера G и p, имеющие минимальное значение d 2 ij Если n 1много больше n 2 , то центры объединения двух кластеровблизки друг к другу и характеристикивторого кластера при объединении кластеров практически игнорируются.Иногда этот метод иногда называют еще методом взвешенных групп.

3.Алгоритм последовательной кластеризации

Рассмотрим Ι = (Ι 1 ,Ι 2 , … Ι n) как множествокластеров {Ι 1 }, {Ι 2 },…{Ι n }. Выберем два из них, например, Ι iи Ι j, которые внекотором смысле более близки друг к другу и объединим их в один кластер. Новоемножество кластеров, состоящее уже из n-1 кластеров, будет:

{Ι 1 }, {Ι 2 }…,{Ι i , Ι j },…, {Ι n }.

Повторяя процесс, получим последовательные множества кластеров, состоящиеиз (n-2), (n-3), (n–4) и т.д. кластеров. Вконце процедуры можно получить кластер, состоящий из n объектов и совпадающий спервоначальным множеством Ι =(Ι 1 , Ι 2 , … Ι n).

В качестве меры расстояния возьмем квадрат евклидовой метрикиd i j 2.и вычислим матрицу D = {d i j 2 },где d i j 2 — квадрат расстояния между

Ι iи Ι j:

….

Ι n

d 12 2

d 13 2

….

d 1n 2

d 23 2

….

d 2n 2

….

d 3n 2

….

….

….

Ι n

Пустьрасстояние между Ι i и Ι jбудет минимальным:

d i j 2 = min {d i j 2 , i¹ j}.Образуемс помощью Ι i и Ι jновый кластер

{Ι i ,Ι j }. Построим новую ((n-1), (n-1))матрицу расстояния

{Ι i , Ι j }

….

Ι n

{Ι i ; Ι j }

d i j 2 1

d i j 2 2

….

d i j 2 n

d 12 2

d 1 3

….

d 1 2 n

….

d 2 n

….

d 3n

(n-2) строкидля последней матрицы взяты из предыдущей, а первая строка вычислена заново.Вычисления могут быть сведеныкминимуму, если удастся выразить d i j 2 k ,k= 1, 2,…,n; (k¹i¹ j) черезэлементы первоначальной матрицы.

Исходно определено расстояние лишь между одноэлементными кластерами, нонадо определять расстояния и между кластерами, содержащими более чем одинэлемент. Это можно сделать различными способами, и в зависимости от выбранногоспособа мы получают алгоритмы кластер анализа с различными свойствами. Можно,например, положить расстояние между кластером i + jи некоторым другимкластером k, равным среднемуарифметическому из расстояний между кластерами i и k и кластерами j и k:

d i+j,k = ½ (d i k + d j k).

Но можнотакже определить d i+j,k как минимальное изэтих двух расстояний:

d i+j,k = min (d ik + d j k).

Таким образом, описан первый шаг работы агломеративного иерархическогоалгоритма. Последующие шаги аналогичны.

Довольно широкий класс алгоритмов может быть получен, если дляперерасчета расстояний использовать следующую общую формулу:

d i+j,k = A(w) min(d ik d jk) + B(w) max(d ikd jk),где

A(w) = ,если d ik£ d jk

A(w) = ,если d ik> d jk

B(w) = ,если d i k£ d jk

B(w) =, еслиd ik>d jk

где n i и n j — числоэлементов в кластерах i и j, а w – свободный параметр, выборкоторого определяет конкретный алгоритм. Например, при w = 1 мыполучаем, так называемый, алгоритм «средней связи», для которого формулаперерасчета расстояний принимает вид:

d i+j,k =

В данном случае расстояние между двумякластерами на каждом шаге работы алгоритма оказывается равным среднемуарифметическому из расстояний между всеми такими парами элементов, что одинэлемент пары принадлежитк одномукластеру, другой — к другому.

Наглядный смысл параметра wстановится понятным, если положить w®¥.Формула пересчета расстояний принимает вид:

d i+j,k =min (d i,kd jk)

Это будеттак называемый алгоритм«ближайшего соседа», позволяющий выделять кластеры сколь угодно сложной формыпри условии, что различные части таких кластеров соединены цепочками близкихдруг к другу элементов. В данном случае расстояние между двумя кластерами накаждом шаге работы алгоритма оказывается равным расстоянию между двумя самымиблизкими элементами, принадлежащими к этим двум кластерам.

Довольно часто предполагают, что первоначальные расстояния (различия)между группируемыми элементамизаданы.В некоторыхзадачах это действительнотак. Однако, задаются только объекты и их характеристики и матрицу расстоянийстроят исходя из этих данных. В зависимости от того, вычисляются ли расстояниямежду объектами или между характеристиками объектов, используются разныеспособы.

В случае кластер анализа объектов наиболее часто мерой различия служитлибо квадрат евклидова расстояния

![]()

(где x ih , x jh -значения h-го признака для i-го и j-го объектов, а m -число характеристик), либо само евклидово расстояние. Если признакамприписывается разный вес, то эти веса можно учесть при вычислении расстояния

![]()

Иногда в качестве мерыразличияиспользуется расстояние,вычисляемое по формуле:

![]()

которыеназывают: «хэмминговым», «манхэттенским» или»сити-блок» расстоянием.

Естественноймерой сходствахарактеристик объектов во многих задачах является коэффициент корреляции междуними

где m i ,m j ,d i ,d j — соответственно средние исреднеквадратичные отклонения для характеристик i и j. Мерой различиямежду характеристиками может служить величина1 — r. В некоторыхзадачахзнак коэффициента корреляциинесуществен и зависит лишь отвыбораединицы измерения. В этом случае в качестве меры различиямежду характеристиками используется ô1 — r i j ô

4. Числокластеров

Очень важным вопросом является проблема выбора необходимого числа кластеров.Иногда можно m числокластеров выбирать априорно. Однако в общем случае это число определяется впроцессе разбиениямножества накластеры.

Проводились исследования Фортьером и Соломоном, и было установлено, чточисло кластеров должно быть принято для достижения вероятности a того, что найдено наилучшее разбиение. Такимобразом, оптимальное число разбиений является функцией заданной доли b наилучших или в некотором смысле допустимыхразбиений во множествевсех возможных.Общее рассеяние будет тем больше, чем выше доля bдопустимых разбиений. Фортьер и Соломон разработали таблицу, по которой можнонайти число необходимых разбиений. S(a,b) в зависимости от aи b (где a — вероятность того, что найдено наилучшееразбиение, b— доля наилучших разбиений в общем числе разбиений) Причем в качестве мерыразнородности используется не мера рассеяния, а мера принадлежности, введеннаяХользенгером и Харманом. Таблица значений S(a,b)приводитсяниже.

Довольно часто критерием объединения (числа кластеров) становитсяизменение соответствующей функции. Например, суммы квадратов отклонений:

Процессу группировки должно соответствовать здесь последовательноеминимальное возрастание значения критерия E. Наличие резкого скачкав значении E можно интерпретировать какхарактеристику числа кластеров, объективно существующих в исследуемойсовокупности.

Итак, второй способ определения наилучшего числа кластеров сводится квыявлению скачков, определяемых фазовым переходом от сильно связанного кслабосвязанному состоянию объектов.

5.Дендограммы

Наиболее известный метод представления матрицы расстояний или сходстваоснован на идее дендограммы или диаграммы дерева. Дендограмму можно определитькак графическое изображение результатов процессапоследовательной кластеризации, которая осуществляется в терминахматрицы расстояний. С помощью дендограммы можно графически или геометрическиизобразить процедуру кластеризации при условии, что эта процедура оперируеттолькос элементами матрицы расстоянийили сходства.

Существуетмного способовпостроения дендограмм. В дендограмме объектырасполагаются вертикально слева, результатыкластеризации – справа. Значения расстояний или сходства,отвечающие строению новых кластеров, изображаются по горизонтальной прямой поверхдендограмм.

Рис1

На рисунке 1 показан один из примеровдендограммы. Рис 1 соответствует случаюшести объектов (n=6) иkхарактеристик (признаков). Объекты Аи С наиболее близки и поэтомуобъединяются в один кластер на уровне близости, равном 0,9. ОбъектыD и Е объединяютсяпри уровне 0,8. Теперь имеем 4 кластера:

(А, С), (F), (D,E), (B).

Далее образуются кластеры (А, С,F) и (E,D,B),соответствующие уровню близости, равному 0,7 и 0,6. Окончательно все объектыгруппируются в один кластер при уровне 0,5.

Вид дендограммы зависит от выбора меры сходстваили расстояния между объектоми кластером и метода кластеризации. Наиболееважным моментом является выбор меры сходства или меры расстояния между объектоми кластером.

Число алгоритмов кластерного анализа слишком велико.Все их можноподразделить наиерархическиеи неиерархические.

Иерархические алгоритмы связаны с построениемдендограмм и делятся на:

а) агломеративные, характеризуемые последовательнымобъединениемисходных элементов исоответствующим уменьшением числа кластеров;

б) дивизимные (делимые), в которых число кластероввозрастает, начиная с одного, в результате чего образуетсяпоследовательностьрасщепляющих групп.

Алгоритмы кластерного анализа имеют сегодня хорошую программную реализацию, котораяпозволяет решить задачи самой большой размерности.

6.Данные

Кластерный анализ можно применять к интервальным данным, частотам,бинарным данным. Важно, чтобы переменные изменялись в сравнимых шкалах.

Неоднородность единиц измерения и вытекающая отсюда невозможностьобоснованного выражения значений различных показателей в одном масштабеприводит к тому, что величина расстояний между точками, отражающими положениеобъектов в пространстве их свойств, оказывается зависящей от произвольноизбираемого масштаба. Чтобы устранить неоднородность измерения исходных данных,все их значения предварительно нормируются, т.е. выражаются через отношениеэтих значенийк некоторой величине,отражающей определенные свойства данного показателя. Нормирование исходныхданных для кластерного анализа иногда проводится посредством деления исходныхвеличин на среднеквадратичное отклонение соответствующих показателей. Другойспособ сводиться к вычислению, так называемого, стандартизованного вклада. Егоеще называютZ-вкладом.

Z-вклад показывает, сколько стандартных отклоненийотделяет данное наблюдение от среднего значения:

Гдеx i – значение данного наблюдения, – среднее,S – стандартное отклонение.

Среднее дляZ-вкладов является нулевым истандартное отклонение равно 1.

Стандартизация позволяет сравнивать наблюдения из различныхраспределений. Если распределение переменной является нормальным (или близким кнормальному), и средняя и дисперсия известны или оцениваются по большимвыборным, тоZ-вклад для наблюденияобеспечивает более специфическую информацию о его расположении.

Заметим, что методы нормирования означают признание всех признаковравноценными с точки зрения выяснения сходства рассматриваемых объектов. Ужеотмечалось, что применительно к экономике признание равноценности различныхпоказателей кажется оправданным отнюдь не всегда. Было бы, желательным наряду снормированием придать каждому из показателей вес, отражающий его значимость входе установления сходств и различий объектов.

В этой ситуации приходится прибегать к способу определения весовотдельных показателей – опросу экспертов. Например, при решении задачи оклассификации стран по уровню экономического развития использовались результатыопроса 40 ведущих московских специалистов по проблемам развитых стран подесятибалльной шкале:

обобщенные показатели социально-экономического развития – 9 баллов;

показатели отраслевого распределения занятого населения – 7 баллов;

показатели распространенности наемного труда – 6 баллов;

показатели, характеризующие человеческий элемент производительных сил –6 баллов;

показатели развития материальных производительных сил – 8 баллов;

показатель государственных расходов – 4балла;

«военно-экономические» показатели – 3 балла;

социально-демографические показатели – 4 балла.

Оценки экспертов отличались сравнительно высокой устойчивостью.

Экспертные оценки дают известное основание для определения важностииндикаторов, входящих в ту или иную группу показателей. Умножение нормированныхзначений показателей на коэффициент, соответствующий среднему баллу оценки,позволяет рассчитывать расстояния между точками, отражающими положение стран вмногомерном пространстве, с учетом неодинакового веса их признаков.

Довольно часто при решенииподобных задач используют не один, а два расчета: первый, в котором всепризнаки считаются равнозначными, второй, где им придаются различные веса всоответствии со средними значениями экспертных оценок.

7.Применение кластерного анализа

Рассмотрим некоторые приложения кластерного анализа.

1.Деление стран на группыпо уровню развития.

Изучались 65 стран по 31 показателю (национальный доход на душунаселения, доля населения занятого в промышленности в %, накопления на душунаселения, доля населения, занятого в сельском хозяйстве в %, средняяпродолжительность жизни, число автомашин на 1 тыс. жителей, численностьвооруженных сил на 1 млн. жителей, доля ВВП промышленности в %, доля ВВПсельского хозяйства в %, и т.д.)

Каждая из стран выступает в данном рассмотрении как объект,характеризуемый определенными значениями 31 показателя. Соответственно онимогут быть представлены в качестве точек в 31-мерном пространстве. Такоепространство обычно называется пространством свойств изучаемых объектов. Сравнениерасстояния между этими точками будетотражать степень близости рассматриваемых стран, их сходство друг с другом.Социально-экономический смысл подобного понимания сходства означает, что странысчитаются тем более похожими, чем меньше различия между одноименнымипоказателями, с помощью которых они описываются.

Первый шаг подобного анализа заключается в выявлении пары народныххозяйств, учтенных в матрице сходства, расстояние между которыми являетсянаименьшим. Это, очевидно, будут наиболее сходные, похожие экономики. Впоследующем рассмотрении обе эти страны считаются единой группой, единымкластером. Соответственно исходная матрица преобразуется так, что ее элементамистановятся расстояния между всеми возможными парами уже не 65, а 64 объектами –63 экономики и вновь преобразованного кластера – условного объединения двухнаиболее похожих стран. Из исходной матрицы сходства выбрасываются строки истолбцы, соответствующие расстояниям от пары стран, вошедших в объедение, довсех остальных, но зато добавляются строка и столбец, содержащие расстояниемежду кластером, полученным при объединении и прочими странами.

Расстояние между вновь полученным кластером и странами полагаетсяравным среднему из расстояний между последними и двумя странами, которые составляютновый кластер. Иными словами, объединенная группа стран рассматривается какцелоес характеристиками, примерноравными средним из характеристик входящих в него стран.

Второй шаг анализа заключается в рассмотрении преобразованной такимпутем матрицы с 64 строками и столбцами. Снова выявляется пара экономик,расстояние между которыми имеет наименьшее значение, и они, так же как в первомслучае, сводятся воедино. При этом наименьшее расстояниеможет оказаться как между парой стран,таки между какой-либо странойи объединением стран, полученным напредыдущем этапе.

Дальнейшие процедуры аналогичны описанным выше: на каждом этапе матрицапреобразуется так, что из нее исключаются два столбца и две строки, содержащиерасстояние до объектов (пар стран или объединений – кластеров), сведенныхвоедино на предыдущей стадии; исключенные строки и столбцы заменяютсястолбцоми строкой, содержащимирасстояния от новых объединений до остальных объектов; далее в измененной матрицевыявляется пара наиболее близких объектов. Анализ продолжается до полногоисчерпания матрицы (т. е. до тех пор, пока все страны не окажутся сведенными водно целое). Обобщенные результаты анализа матрицы можно представить в видедерева сходства (дендограммы), подобного описанному выше, с той лишь разницей,что дерево сходства, отражающее относительную близость всех рассматриваемыхнами 65 стран, много сложнее схемы, в которой фигурирует только пять народныххозяйств. Это дерево в соответствиисчислом сопоставляемых объектов включает 65 уровней. Первый (нижний) уровеньсодержит точки, соответствующие каждых стране в отдельности. Соединение двухэтих точек на втором уровне показывает пару стран, наиболее близких по общемутипу народных хозяйств. На третьем уровне отмечается следующее по сходствупарное соотношение стран (как уже упоминалось, в таком соотношении можетнаходиться либо новая пара стран, либо новая странаи уже выявленная пара сходных стран). И так далее до последнегоуровня, на котором все изучаемые страны выступают как единая совокупность.

В результате применения кластерного анализа были получены следующие пятьгрупп стран:

·афро-азиатская группа;

·латино-азиатская группа;

·латино-среднеземнаморская группа;

·группа развитых капиталистических стран (без США)

·США

Введение новых индикаторов сверх используемого здесь 31 показателя илизамена их другими, естественно, приводят к изменению результатов классификациистран.

2. Деление стран по критерию близости культуры.

Как известно маркетинг должен учитывать культуру стран (обычаи, традиции,и т.д.).

Посредством кластеризации были получены следующие группы стран:

·арабские;

·ближневосточные;

·скандинавские;

·германоязычные;

·англоязычные;

·романские европейские;

·латиноамериканские;

·дальневосточные.

3. Разработка прогноза конъюнктуры рынка цинка.

Кластерный анализ играет важную рольна этапе редукции экономико-математической модели товарной конъюнктуры,способствуя облегчению и упрощению вычислительных процедур, обеспечению большейкомпактности получаемых результатов при одновременном сохранении необходимойточности. Применение кластерного анализа дает возможность разбить всю исходнуюсовокупность показателей конъюнктуры на группы (кластеры) по соответствующимкритериям, облегчая тем самым выбор наиболее репрезентативных показателей.

Кластерный анализ широко используется для моделирования рыночнойконъюнктуры. Практически основное большинство задач прогнозирования опираетсянаиспользование кластерного анализа.

Например, задача разработки прогноза конъюнктуры рынка цинка.

Первоначально было отобрано 30 основных показателей мирового рынка цинка:

Х 1 — время

Показатели производства:

Х 2 — в мире

Х 4 — Европе

Х 5 — Канаде

Х 6 — Японии

Х 7 — Австралии

Показатели потребления:

Х 8 — в мире

Х 10 — Европе

Х 11 — Канаде

Х 12 — Японии

Х 13 — Австралии

Запасы цинка у производителей:

Х 14 — в мире

Х 16 — Европе

Х 17 — других странах

Запасы цинка у потребителей:

Х 18 — в США

Х 19 — в Англии

Х 10 — в Японии

Импорт цинковых руд иконцентратов (тыс. тонн)

Х 21 — в США

Х 22 — в Японии

Х 23 — в ФРГ

Экспорт цинковых руд иконцентратов (тыс. тонн)

Х 24 — из Канады

Х 25 — из Австралии

Импорт цинка (тыс. тонн)

Х 26 — в США

Х 27 — в Англию

Х 28 — в ФРГ

Экспорт цинка (тыс. Тонн)

Х 29 -из Канады

Х 30 — из Австралии

Для определения конкретныхзависимостейбыл использован аппарат корреляционно-регрессионногоанализа. Анализ связей производился на основе матрицы парныхкоэффициентов корреляции. Здесь принималась гипотеза о нормальном распределениианализируемых показателей конъюнктуры.Ясно, что r ijявляются не единственно возможным показателем связи используемых показателей.Необходимость использования кластерного анализа связано в этой задачес тем, что число показателей влияющих нацену цинка очень велико. Возникаетнеобходимость их сократить по целому ряду следующих причин:

а) отсутствие полных статистических данных по всем переменным;

б) резкое усложнение вычислительных процедур при введении в модельбольшого числа переменных;

в) оптимальное использование методов регрессионного анализа требуетпревышения числа наблюдаемых значений над числом переменных не менее, чем в 6-8раз;

г) стремление к использованию в модели статистически независимыхпеременных и пр.

Проводить такой анализ непосредственно на сравнительно громоздкой матрицекоэффициентов корреляции весьма затруднительно. С помощью кластерного анализавсю совокупность конъюнктурных переменных можно разбить на группы такимобразом, чтобы элементы каждого кластера сильно коррелировали между собой, апредставители разных групп характеризовались слабой коррелированностью.

Для решения этой задачи был применен один из агломеративных иерархическихалгоритмов кластерного анализа. На каждом шаге число кластеров уменьшается наодин за счет оптимального, в определенном смысле, объединения двух групп.Критерием объединения является изменение соответствующей функции. В качествефункции такой были использованы значения сумм квадратов отклонений вычисляемыепо следующим формулам:

(j = 1, 2, …,m),

где j — номер кластера, n — число элементов в кластере.

r ij -коэффициент парной корреляции.

Таким образом, процессу группировки должно соответствоватьпоследовательное минимальное возрастание значения критерия E.

На первом этапе первоначальный массив данных представляется в виде множества,состоящего из кластеров, включающих в себя по одному элементу. Процессгруппировки начинается с объединения такой пары кластеров, которое приводит кминимальному возрастанию суммы квадратов отклонений. Это требует оценкизначений суммы квадратов отклонений для каждогоиз возможных объединенийкластеров. На следующем этапе рассматриваются значения сумм квадратовотклонений уже для кластеров и т.д.Этот процесс будет остановлен на некотором шаге. Для этого нужно следить завеличиной суммы квадратов отклонений. Рассматривая последовательностьвозрастающих величин, можно уловить скачок (один или несколько) в ее динамике,который можно интерпретировать как характеристику числа групп «объективно»существующих в исследуемойсовокупности. В приведенном примере скачки имели место при числекластеров равном 7 и 5. Далее снижать число групп не следует, т.к. это приводитк снижению качества модели. После получения кластеров происходит выборпеременных наиболее важных в экономическом смысле и наиболее тесно связанных свыбранным критерием конъюнктуры — в данном случае с котировками Лондонскойбиржи металлов на цинк. Этот подход позволяет сохранить значительную частьинформации, содержащейся в первоначальном наборе исходных показателейконъюнктуры.

Часто в самых различных областях деятельности нам приходится иметь дело с огромным количеством каких-либо предметов, в отношении которых требуется принять меры. А мы не можем даже осознать весь этот объем, а не то что разобраться в нем.

Какой же выход? Ну, конечно, «разложить все по полочкам». В данном случае народная мудрость обретает вполне определенную научную формулировку.

Кластерный анализ – это исследование объектов путем объединения их по однородным группам со схожими признаками. Его методы применимы буквально во всех сферах: от медицины до торговли на Форекс, от автострахования до археологии. А для маркетологов и спецов по кадрам он просто незаменим.

Об этом подробнее – в статье.

Что такое кластер

Кластерный анализ предназначен для разбиения совокупности объектов на однородные группы (кластеры или классы). Это задача многомерной классификации данных.

Существует около 100 разных алгоритмов кластеризации, однако, наиболее часто используемые:

- иерархический кластерный анализ,

- кластеризация методом k-средних.

Где применяется кластерный анализ:

- В маркетинге это сегментация конкурентов и потребителей.

- В менеджменте:

- разбиение персонала на различные по уровню мотивации группы,

- классификация поставщиков,

- выявление схожих производственных ситуаций, при которых возникает брак.

- В медицине — классификация симптомов, пациентов, препаратов.

- В социологии — разбиение респондентов на однородные группы.

По сути кластерный анализ хорошо зарекомендовал себя во всех сферах жизнедеятельности человека. Прелесть данного метода — он работает даже тогда, когда данных мало и не выполняются требования нормальности распределений случайных величин и другие требования классических методов статистического анализа.

Поясним суть кластерного анализа, не прибегая к строгой терминологии.

Допустим, Вы провели анкетирование сотрудников и хотите определить, каким образом можно наиболее эффективно управлять персоналом. То есть Вы хотите разделить сотрудников на группы и для каждой из них выделить наиболее эффективные рычаги управления. При этом различия между группами должны быть очевидными, а внутри группы респонденты должны быть максимально похожи.

Для решения задачи предлагается использовать иерархический кластерный анализ. В результате мы получим дерево, глядя на которое мы должны определиться, на сколько классов (кластеров) мы хотим разбить персонал. Предположим, что мы решили разбить персонал на три группы, тогда для изучения респондентов, попавших в каждый кластер получим табличку примерно следующего содержания:

Поясним, как сформирована приведенная выше таблица. В первом столбце расположен номер кластера — группы, данные по которой отражены в строке. Например, первый кластер на 80% составляют мужчины. 90% первого кластера попадают в возрастную категорию от 30 до 50 лет, а 12% респондентов считает, что льготы очень важны. И так далее.

Попытаемся составить портреты респондентов каждого кластера:

- Первая группа — в основном мужчины зрелого возраста, занимающие руководящие позиции. Соцпакет (MED, LGOTI, TIME-свободное время) их не интересует. Они предпочитают получать хорошую зарплату, а не помощь от работодателя.

- Группа два — наоборот, отдает предпочтение соцпакету. Состоит она, в основном, из людей «в возрасте», занимающих невысокие посты. Зарплата для них безусловно важна, но есть и другие приоритеты.

- Третья группа — наиболее «молодая». В отличие от предыдущих двух, очевиден интерес к возможностям обучения и профессионального роста. У этой категории сотрудников есть хороший шанс в скором времени пополнить первую группу.

Таким образом, планируя кампанию по внедрению эффективных методов управления персоналом, очевидно, что в нашей ситуации можно увеличить соцпакет у второй группы в ущерб, к примеру, зарплате. Если говорить о том, каких специалистов следует направлять на обучение, то можно однозначно рекомендовать обратить внимание на третью группу.

Источник: «nickart.spb.ru»

Кластерный анализ — это ключ к пониманию рынка

Кластер — это цена актива в определенный промежуток времени, на котором совершались сделки. Результирующий объем покупок и продаж указан цифрой внутри кластера. Бар любого ТФ вмещает в себя, как правило, несколько кластеров. Это позволяет детально видеть объемы покупок, продаж и их баланс в каждом отдельном баре, по каждому ценовому уровню.

Построение кластерного графика

Изменение цены одного актива неизбежно влечет за собой цепочку ценовых движений и на других инструментах. В большинстве случаев понимание трендового движения происходит уже в тот момент, когда оно бурно развивается, и вход в рынок по тренду чреват попаданием в коррекционную волну.

Для успешных сделок необходимо понимать текущую ситуацию и уметь предвидеть будущие ценовые движения. Этому можно научиться, анализируя график кластеров. С помощью кластерного анализа можно видеть активность участников рынка внутри даже самого маленького ценового бара.

Это наиболее точный и детальный анализ, так как показывает точечное распределение объемов сделок по каждому ценовому уровню актива. На рынке постоянно идет противоборство интересов продавцов и покупателей. И каждое самое маленькое движение цены (тик), является тем ходом к компромиссу – ценовому уровню — который в данный момент устраивает обе стороны.

Но рынок динамичен, количество продавцов и покупателей непрерывно изменяется. Если в один момент времени на рынке доминировали продавцы, то в следующий момент, вероятнее всего, будут покупатели. Не одинаковым оказывается и количество совершенных сделок на соседних ценовых уровнях.

И все же сначала рыночная ситуация отражается на суммарных объемах сделок, а уж затем на цене. Если видеть действия доминирующих участников рынка (продавцов или покупателей), то можно предсказывать и само движение цены.

Для успешного применения кластерного анализа прежде всего следует понять, что такое кластер и дельта:

- Кластером называют ценовое движение, которое разбито на уровни, на которых совершались сделки с известными объемами.

- Дельта показывает разницу между покупками и продажами, происходящими в каждом кластере.

Кластерный график

Каждый кластер, или группа дельт, позволяет разобраться в том, покупатели или продавцы преобладают на рынке в данный момент времени. Достаточно лишь подсчитать общую дельту, просуммировав продажи и покупки. Если дельта отрицательна, то рынок перепродан, на нем избыточными являются сделки на продажу. Когда же дельта положительна, то на рынке явно доминируют покупатели.

Сама дельта может принимать нормальное или критическое значение. Значение объема дельты сверх нормального в кластере выделяют красным цветом. Если дельта умеренна, то это характеризует флетовое состояние на рынке. При нормальном значении дельты на рынке наблюдается трендовое движение, а вот критическое значение всегда является предвестником разворота цены.

Торговля на Форекс с помощью КА

Для получения максимальной прибыли нужно уметь определить переход дельты из умеренного уровня в нормальный. Ведь в этом случае можно заметить само начало перехода от флета к трендовому движению и суметь получить наибольшую прибыль.

Более наглядным является кластерный график, на нем можно увидеть значимые уровни накопления и распределения объемов, построить уровни поддержки и сопротивления.

Это позволяет трейдеру найти точный вход в сделку. Используя дельту, можно судить о преобладании на рынке продаж или покупок. Кластерный анализ позволяет наблюдать сделки и отслеживать их объемы внутри бара любого ТФ. Особо это важно при подходе к значимым уровням поддержки или сопротивления. Суждения по кластерам — ключ к пониманию рынка.

Источник: «orderflowtrading.ru»

Области и особенности применения анализа кластеров

Термин кластерный анализ (впервые ввел Tryon, 1939) в действительности включает в себя набор различных алгоритмов классификации. Общий вопрос, задаваемый исследователями во многих областях, состоит в том, как организовать наблюдаемые данные в наглядные структуры, т.е. развернуть таксономии.

Например, биологи ставят цель разбить животных на различные виды, чтобы содержательно описать различия между ними. В соответствии с современной системой, принятой в биологии, человек принадлежит к приматам, млекопитающим, амниотам, позвоночным и животным.

Заметьте, что в этой классификации чем выше уровень агрегации, тем меньше сходства между членами в соответствующем классе. Человек имеет больше сходства с другими приматами (т.е. с обезьянами), чем с «отдаленными» членами семейства млекопитающих (например, собаками) и т.д.

Заметим, что предыдущие рассуждения ссылаются на алгоритмы кластеризации, но ничего не упоминают о проверке статистической значимости. Фактически, кластерный анализ является не столько обычным статистическим методом, сколько «набором» различных алгоритмов «распределения объектов по кластерам».

Существует точка зрения, что в отличие от многих других статистических процедур, методы кластерного анализа используются в большинстве случаев тогда, когда вы не имеете каких-либо априорных гипотез относительно классов, но все еще находитесь в описательной стадии исследования. Следует понимать, что кластерный анализ определяет «наиболее возможно значимое решение».

Поэтому проверка статистической значимости в действительности здесь неприменима, даже в случаях, когда известны p-уровни (как, например, в методе K средних).

Техника кластеризации применяется в самых разнообразных областях. Хартиган (Hartigan, 1975) дал прекрасный обзор многих опубликованных исследований, содержащих результаты, полученные методами кластерного анализа. Например, в области медицины кластеризация заболеваний, лечения заболеваний или симптомов заболеваний приводит к широко используемым таксономиям.

В области психиатрии правильная диагностика кластеров симптомов, таких как паранойя, шизофрения и т.д., является решающей для успешной терапии. В археологии с помощью кластерного анализа исследователи пытаются установить таксономии каменных орудий, похоронных объектов и т.д.

Известны широкие применения кластерного анализа в маркетинговых исследованиях. В общем, всякий раз, когда необходимо классифицировать «горы» информации к пригодным для дальнейшей обработки группам, кластерный анализ оказывается весьма полезным и эффективным.

Древовидная кластеризация

Назначение алгоритма объединения (древовидной кластеризации) состоит в объединении объектов (например, животных) в достаточно большие кластеры, используя некоторую меру сходства или расстояние между объектами. Типичным результатом такой кластеризации является иерархическое дерево.

Рассмотрим горизонтальную древовидную диаграмму. Диаграмма начинается с каждого объекта в классе (в левой части диаграммы). Теперь представим себе, что постепенно (очень малыми шагами) вы «ослабляете» ваш критерий о том, какие объекты являются уникальными, а какие нет. Другими словами, вы понижаете порог, относящийся к решению об объединении двух или более объектов в один кластер.

В результате, вы связываете вместе все большее и большее число объектов и агрегируете (объединяете) все больше и больше кластеров, состоящих из все сильнее различающихся элементов. Окончательно, на последнем шаге все объекты объединяются вместе.

На этих диаграммах горизонтальные оси представляют расстояние объединения (в вертикальных древовидных диаграммах вертикальные оси представляют расстояние объединения). Так, для каждого узла в графе (там, где формируется новый кластер) вы можете видеть величину расстояния, для которого соответствующие элементы связываются в новый единственный кластер.

Когда данные имеют ясную «структуру» в терминах кластеров объектов, сходных между собой, тогда эта структура, скорее всего, должна быть отражена в иерархическом дереве различными ветвями. В результате успешного анализа методом объединения появляется возможность обнаружить кластеры (ветви) и интерпретировать их.

Меры расстояния

Объединение или метод древовидной кластеризации используется при формировании кластеров несходства или расстояния между объектами. Эти расстояния могут определяться в одномерном или многомерном пространстве. Например, если вы должны кластеризовать типы еды в кафе, то можете принять во внимание количество содержащихся в ней калорий, цену, субъективную оценку вкуса и т.д.

Наиболее прямой путь вычисления расстояний между объектами в многомерном пространстве состоит в вычислении евклидовых расстояний. Если вы имеете двух- или трехмерное пространство, то эта мера является реальным геометрическим расстоянием между объектами в пространстве (как будто расстояния между объектами измерены рулеткой).

Однако алгоритм объединения не «заботится» о том, являются ли «предоставленные» для этого расстояния настоящими или некоторыми другими производными мерами расстояния, что более значимо для исследователя; и задачей исследователей является подобрать правильный метод для специфических применений.

- Евклидово расстояние.

- Квадрат евклидова расстояния.

- Расстояние городских кварталов (манхэттенское расстояние).

- Расстояние Чебышева.

- Степенное расстояние.

Иногда желают прогрессивно увеличить или уменьшить вес, относящийся к размерности, для которой соответствующие объекты сильно отличаются. Это может быть достигнуто с использованием степенного расстояния. Степенное расстояние вычисляется по формуле:

где r и p — параметры, определяемые пользователем.

Несколько примеров вычислений могут показать, как «работает» эта мера:

- Параметр p ответственен за постепенное взвешивание разностей по отдельным координатам.

- Параметр r ответственен за прогрессивное взвешивание больших расстояний между объектами.

- Если оба параметра — r и p, равны двум, то это расстояние совпадает с расстоянием Евклида.

- Процент несогласия.

Это, по-видимому, наиболее общий тип расстояния. Оно попросту является геометрическим расстоянием в многомерном пространстве и вычисляется следующим образом:

Заметим, что евклидово расстояние (и его квадрат) вычисляется по исходным, а не по стандартизованным данным. Это обычный способ его вычисления, который имеет определенные преимущества (например, расстояние между двумя объектами не изменяется при введении в анализ нового объекта, который может оказаться выбросом).

Тем не менее, на расстояния могут сильно влиять различия между осями, по координатам которых вычисляются эти расстояния.

К примеру, если одна из осей измерена в сантиметрах, а вы потом переведете ее в миллиметры (умножая значения на 10), то окончательное евклидово расстояние (или квадрат евклидова расстояния), вычисляемое по координатам, сильно изменится, и, как следствие, результаты кластерного анализа могут сильно отличаться от предыдущих.

Иногда может возникнуть желание возвести в квадрат стандартное евклидово расстояние, чтобы придать большие веса более отдаленным друг от друга объектам. Это расстояние вычисляется следующим образом:

Это расстояние является просто средним разностей по координатам. В большинстве случаев эта мера расстояния приводит к таким же результатам, как и для обычного расстояния Евклида.

Однако отметим, что для этой меры влияние отдельных больших разностей (выбросов) уменьшается (так как они не возводятся в квадрат). Манхэттенское расстояние вычисляется по формуле:

Это расстояние может оказаться полезным, когда желают определить два объекта как «различные», если они различаются по какой-либо одной координате (каким-либо одним измерением). Расстояние Чебышева вычисляется по формуле:

Эта мера используется в тех случаях, когда данные являются категориальными. Это расстояние вычисляется по формуле:

Правила объединения или связи

На первом шаге, когда каждый объект представляет собой отдельный кластер, расстояния между этими объектами определяются выбранной мерой. Однако когда связываются вместе несколько объектов, возникает вопрос, как следует определить расстояния между кластерами?

Другими словами, необходимо правило объединения или связи для двух кластеров. Здесь имеются различные возможности: например, вы можете связать два кластера вместе, когда любые два объекта в двух кластерах ближе друг к другу, чем соответствующее расстояние связи.

Другими словами, вы используете «правило ближайшего соседа» для определения расстояния между кластерами; этот метод называется методом одиночной связи. Это правило строит «волокнистые» кластеры, т.е. кластеры, «сцепленные вместе» только отдельными элементами, случайно оказавшимися ближе остальных друг к другу.

Как альтернативу вы можете использовать соседей в кластерах, которые находятся дальше всех остальных пар объектов друг от друга. Этот метод называется метод полной связи. Существует также множество других методов объединения кластеров, подобных тем, что были рассмотрены.

- Одиночная связь (метод ближайшего соседа).

- Полная связь (метод наиболее удаленных соседей).

- Невзвешенное попарное среднее.

- Взвешенное попарное среднее.

- Невзвешенный центроидный метод.

- Взвешенный центроидный метод (медиана).

- Метод Варда.

Как было описано выше, в этом методе расстояние между двумя кластерами определяется расстоянием между двумя наиболее близкими объектами (ближайшими соседями) в различных кластерах.

Это правило должно, в известном смысле, нанизывать объекты вместе для формирования кластеров, и результирующие кластеры имеют тенденцию быть представленными длинными «цепочками».

В этом методе расстояния между кластерами определяются наибольшим расстоянием между любыми двумя объектами в различных кластерах (т.е. «наиболее удаленными соседями»).

Этот метод обычно работает очень хорошо, когда объекты происходят на самом деле из реально различных «рощ».

Если же кластеры имеют в некотором роде удлиненную форму или их естественный тип является «цепочечным», то этот метод непригоден.

В этом методе расстояние между двумя различными кластерами вычисляется как среднее расстояние между всеми парами объектов в них. Метод эффективен, когда объекты в действительности формируют различные «рощи», однако он работает одинаково хорошо и в случаях протяженных («цепочного» типа) кластеров.

Отметим, что в своей книге Снит и Сокэл (Sneath, Sokal, 1973) вводят аббревиатуру UPGMA для ссылки на этот метод, как на метод невзвешенного попарного арифметического среднего — unweighted pair-group method using arithmetic averages.

Метод идентичен методу невзвешенного попарного среднего, за исключением того, что при вычислениях размер соответствующих кластеров (т.е. число объектов, содержащихся в них) используется в качестве весового коэффициента. Поэтому предлагаемый метод должен быть использован, когда предполагаются неравные размеры кластеров.

В книге Снита и Сокэла (Sneath, Sokal, 1973) вводится аббревиатура WPGMA для ссылки на этот метод, как на метод взвешенного попарного арифметического среднего — weighted pair-group method using arithmetic averages.

В этом методе расстояние между двумя кластерами определяется как расстояние между их центрами тяжести.

Снит и Сокэл (Sneath and Sokal (1973)) используют аббревиатуру UPGMC для ссылки на этот метод, как на метод невзвешенного попарного центроидного усреднения — unweighted pair-group method using the centroid average.

Этот метод идентичен предыдущему, за исключением того, что при вычислениях используются веса для учета разницы между размерами кластеров (т.е. числами объектов в них).

Поэтому, если имеются (или подозреваются) значительные отличия в размерах кластеров, этот метод оказывается предпочтительнее предыдущего.

Снит и Сокэл (Sneath, Sokal 1973) использовали аббревиатуру WPGMC для ссылок на него, как на метод невзвешенного попарного центроидного усреднения — weighted pair-group method using the centroid average.

Этот метод отличается от всех других методов, поскольку он использует методы дисперсионного анализа для оценки расстояний между кластерами. Метод минимизирует сумму квадратов (SS) для любых двух (гипотетических) кластеров, которые могут быть сформированы на каждом шаге.

Подробности можно найти в работе Варда (Ward, 1963). В целом метод представляется очень эффективным, однако он стремится создавать кластеры малого размера.

Двувходовое объединение

Ранее этот метод обсуждался в терминах «объектов», которые должны быть кластеризованы. Во всех других видах анализа интересующий исследователя вопрос обычно выражается в терминах наблюдений или переменных. Оказывается, что кластеризация, как по наблюдениям, так и по переменным может привести к достаточно интересным результатам.

Например, представьте, что медицинский исследователь собирает данные о различных характеристиках (переменные) состояний пациентов (наблюдений), страдающих сердечными заболеваниями. Исследователь может захотеть кластеризовать наблюдения (пациентов) для определения кластеров пациентов со сходными симптомами.

В то же самое время исследователь может захотеть кластеризовать переменные для определения кластеров переменных, которые связаны со сходным физическим состоянием. После этого обсуждения, относящегося к тому, кластеризовать наблюдения или переменные, можно задать вопрос, а почему бы не проводить кластеризацию в обоих направлениях?

Модуль Кластерный анализ содержит эффективную двувходовую процедуру объединения, позволяющую сделать именно это. Однако двувходовое объединение используется (относительно редко) в обстоятельствах, когда ожидается, что и наблюдения и переменные одновременно вносят вклад в обнаружение осмысленных кластеров.

Так, возвращаясь к предыдущему примеру, можно предположить, что медицинскому исследователю требуется выделить кластеры пациентов, сходных по отношению к определенным кластерам характеристик физического состояния.

Трудность с интерпретацией полученных результатов возникает вследствие того, что сходства между различными кластерами могут происходить из (или быть причиной) некоторого различия подмножеств переменных. Поэтому получающиеся кластеры являются по своей природе неоднородными.

Возможно это кажется вначале немного туманным; в самом деле, в сравнении с другими описанными методами кластерного анализа, двувходовое объединение является, вероятно, наименее часто используемым методом. Однако некоторые исследователи полагают, что он предлагает мощное средство разведочного анализа данных (за более подробной информацией вы можете обратиться к описанию этого метода у Хартигана (Hartigan, 1975)).

Метод K средних

Этот метод кластеризации существенно отличается от таких агломеративных методов, как Объединение (древовидная кластеризация) и Двувходовое объединение. Предположим, вы уже имеете гипотезы относительно числа кластеров (по наблюдениям или по переменным).

Вы можете указать системе образовать ровно три кластера так, чтобы они были настолько различны, насколько это возможно. Это именно тот тип задач, которые решает алгоритм метода K средних. В общем случае метод K средних строит ровно K различных кластеров, расположенных на возможно больших расстояниях друг от друга.

В примере с физическим состоянием, медицинский исследователь может иметь «подозрение» из своего клинического опыта, что его пациенты в основном попадают в три различные категории. Далее он может захотеть узнать, может ли его интуиция быть подтверждена численно, то есть, в самом ли деле кластерный анализ K средних даст три кластера пациентов, как ожидалось?

Если это так, то средние различных мер физических параметров для каждого кластера будут давать количественный способ представления гипотез исследователя (например, пациенты в кластере 1 имеют высокий параметр 1, меньший параметр 2 и т.д.).

С вычислительной точки зрения вы можете рассматривать этот метод, как дисперсионный анализ «наоборот».

Программа начинает с K случайно выбранных кластеров, а затем изменяет принадлежность объектов к ним, чтобы:

- минимизировать изменчивость внутри кластеров,

- максимизировать изменчивость между кластерами.

Данный способ аналогичен методу «дисперсионный анализ (ANOVA) наоборот» в том смысле, что критерий значимости в дисперсионном анализе сравнивает межгрупповую изменчивость с внутригрупповой при проверке гипотезы о том, что средние в группах отличаются друг от друга.

В кластеризации методом K средних программа перемещает объекты (т.е. наблюдения) из одних групп (кластеров) в другие для того, чтобы получить наиболее значимый результат при проведении дисперсионного анализа (ANOVA). Обычно, когда результаты кластерного анализа методом K средних получены, можно рассчитать средние для каждого кластера по каждому измерению, чтобы оценить, насколько кластеры различаются друг от друга.

В идеале вы должны получить сильно различающиеся средние для большинства, если не для всех измерений, используемых в анализе. Значения F-статистики, полученные для каждого измерения, являются другим индикатором того, насколько хорошо соответствующее измерение дискриминирует кластеры.

Источник: «biometrica.tomsk.ru»

Классификация объектов по характеризующим их признакам

Кластерный анализ (cluster analysis) – совокупность многомерных статистических методов классификации объектов по характеризующим их признакам, разделение совокупности объектов на однородные группы, близкие по определяющим критериям, выделение объектов определенной группы.

Кластер – это группы объектов, выделенные в результате кластерного анализа на основе заданной меры сходства или различий между объектами. Объект – это конкретные предметы исследования, которые необходимо классифицировать. Объектами при классификации выступают, как правило, наблюдения. Например, потребители продукции, страны или регионы, товары и т.п.

Хотя можно проводить кластерный анализ и по переменным. Классификация объектов в многомерном кластерном анализе происходит по нескольким признакам одновременно.Это могут быть как количественные, так и категориальные переменные в зависимости от метода кластерного анализа. Итак, главная цель кластерного анализа – нахождение групп схожих объектов в выборке.

Совокупность многомерных статистических методов кластерного анализа можно разделить на иерархические методы (агломеративные и дивизимные) и неиерархические (метод k-средних, двухэтапный кластерный анализ).

Однако общепринятой классификации методов не существует, и к методам кластерного анализа иногда относят также методы построения деревьев решений, нейронных сетей, дискриминантного анализа, логистической регрессии.